How to Instantiate and Configure an LLM with Ollama - Cómo Instanciar y Configurar un LLM con Ollama [Eng-Esp]

How to Instantiate and Configure an LLM with Ollama

Are you interested in obtaining an LLM degree?

Experience the potential of a highly advanced large language model (LLM) tailored to meet your specific needs by implementing an LLM.

In this tutorial, we will provide a comprehensive step-by-step guide on how to use your own LLM using Ollama. From initial setup to fine-tuning, follow these instructions to unlock new possibilities and elevate your projects to new heights with your own LLM.

Step 1

Visit the Ollama website: https://ollama.com/

Step 2

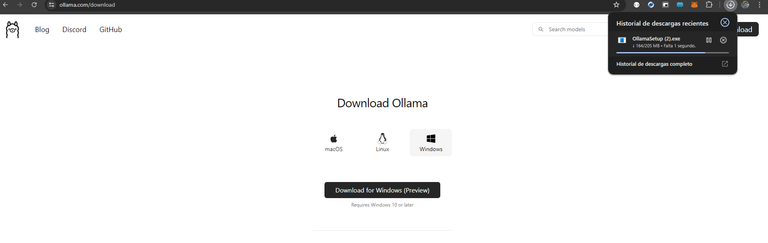

Download the installer.

Step 3

Choose the LLM model you want to instantiate.

Step 4

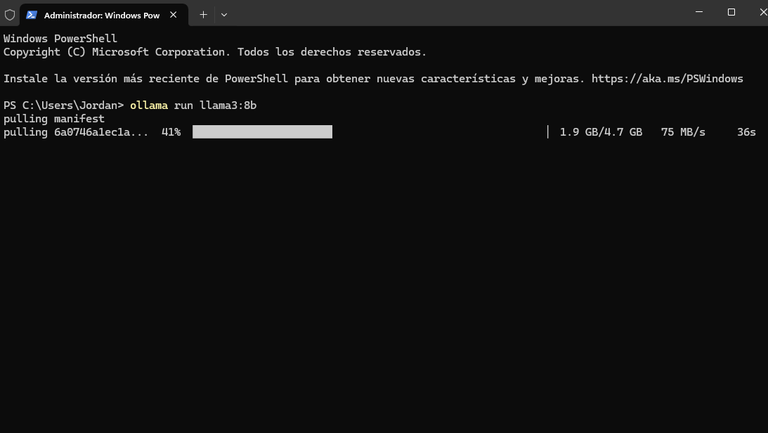

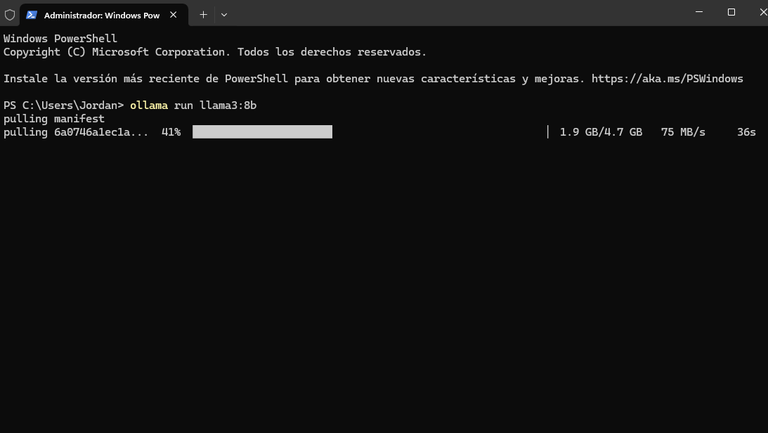

Pull the model you instantiated with the command ollama pull llama3:8b.

Step 5

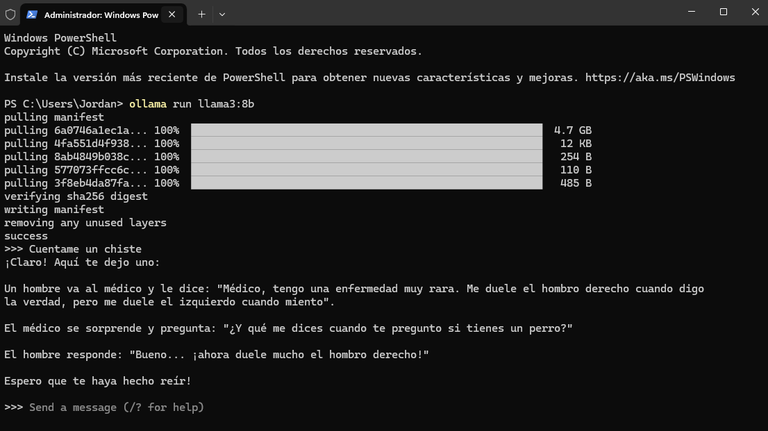

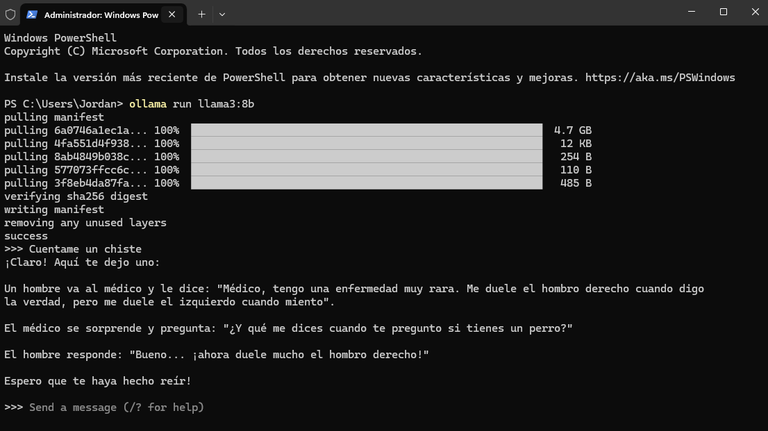

Test the LLM by entering a request such as "tell me a joke".

Using the LLM from Python

Step 1

Install the Ollama library:

pip install ollama

Step 2

Create the code based on the documentation:

import ollama

response = ollama.chat(model='llama2', messages=[

{

'role': 'user',

'content': 'Tell me a joke',

},

])

print(response['message']['content'])

Cómo Instanciar y Configurar un LLM con Ollama

¿Está interesado en obtener un título de LLM?

Experimente el potencial de un modelo de lenguaje grande (LLM) altamente avanzado que se ajusta para satisfacer sus necesidades específicas al implementar un LLM.

En este tutorial, se proporcionará una guía completa paso a paso sobre cómo usar su propio LLM usando Ollama. Desde la configuración inicial hasta el ajuste. Si sigue estas instrucciones, podrá desbloquear nuevas posibilidades y elevar sus proyectos a nuevas alturas con su propio LLM.

Paso 1

Ingrese al sitio web de Ollama: https://ollama.com/

Paso 2

Descargue el instalador.

Paso 3

Elija el modelo LLM que desea instanciar.

Paso 4

Haga pull del modelo que instanció con el comando ollama pull llama3:8b.

Paso 5

Pruebe el LLM ingresando una petición como "cuéntame un chiste".

Usar el LLM desde Python

Paso 1

Instale la librería de Ollama:

pip install ollama

Paso 2

Cree el código basado en la documentación:

import ollama

response = ollama.chat(model='llama2', messages=[

{

'role': 'user',

'content': 'Cuéntame un chiste',

},

])

print(response['message']['content'])